Flume(了解)

用于采集数据

Flume 产生的背景

通过中间系统,将数据推送到 HDFS 或类似的存储系统是很普遍的。这些系统能在数据生产者和最终目的地之间起缓冲作用,使得偶然突发写入 HDFS 和 HBase 集群的请求,变得可以持续而平稳

Flume 简介

Flume 是 Cloudera 提供的一个高可用、高可靠、分布式的海量日志采集、聚合和传输的系统

Apache Flume 是一个系统,用于从大量数据生产商那里移动海量数据到存储、索引或分析数据的系统

Flume 安装

不支持windows安装

需要配置环境变量

Flume的架构

Agent

Flume 运行的核心是 Agent。 Agent 本身是一个 Java 进程,也是 Flume 中最小的独立运行单位,运行在日志收集节点。

Flume核心Agent = source(采集) + channel(缓存数据) + sink(保存日志)

一般一个机器运行一个Agent, 但在一个Agent中可以包含多个Source,channel和sink

event

Flume 基于数据流进行设计,数据流由事件( Event)贯穿始终。事件作为 Flume 的基本数据单位,携带日志数据(以字节数组形式)并且携带有头信息,由 Agent 外部的数据源(如图 7-2 中的 Web Server)生成

Flume 应用

Flume的组件类型及其配置

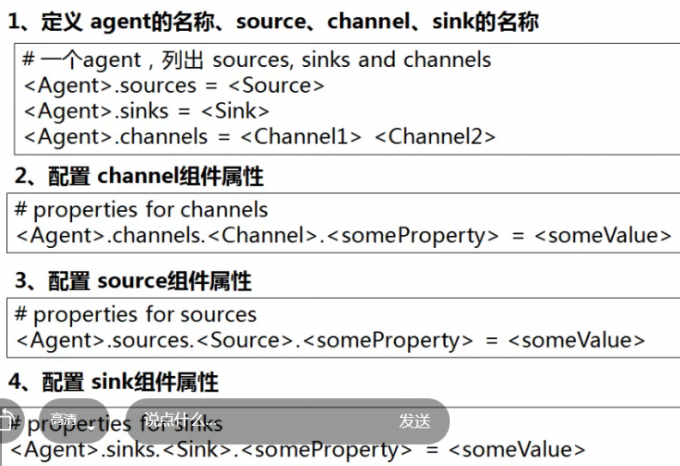

Flume的配置方法

一定义,三配置