下载文件到本地 get: /hdfs1.txt.COPYING (Permission denied)

权限问题

使用java api 操作hdfs时不能 端口拒绝访问call from …

- 防火墙没有关闭

sudo ufw status

sudo ufw disable

- hdfs没打开

start-all.sh

safeModeException

没有关闭安全模式:hdsf dfsadmin -safemode leave

状态:hdfs dfsadmin -safemode get

进入:hdfs dfsadmin -safemode enter

使用JavaAPI操作HDFS创建目录和权限问题

第一种方式://指定当前用户为root用户

System.setProperty(“HADOOP_USER_NAME”, “root”);

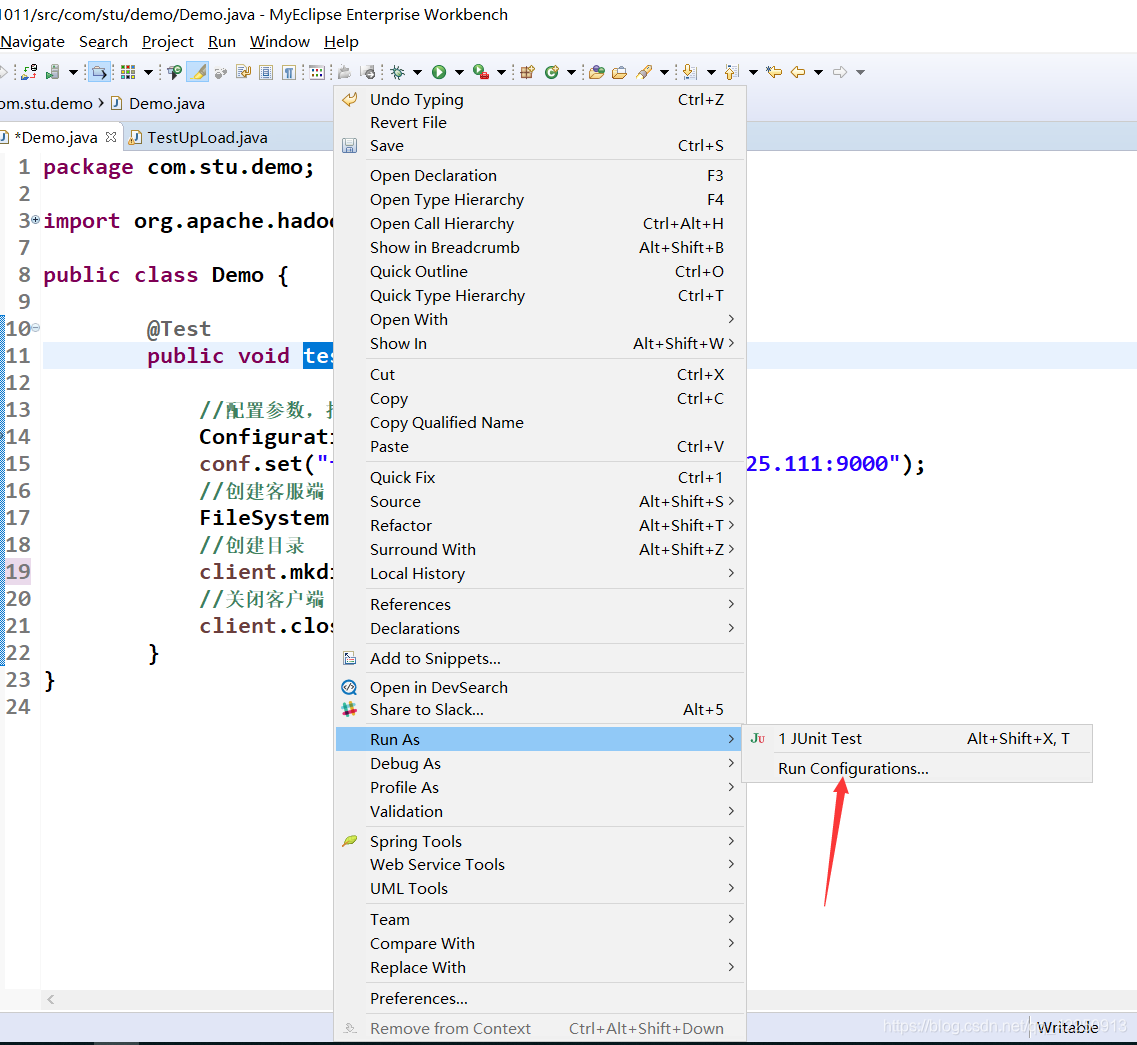

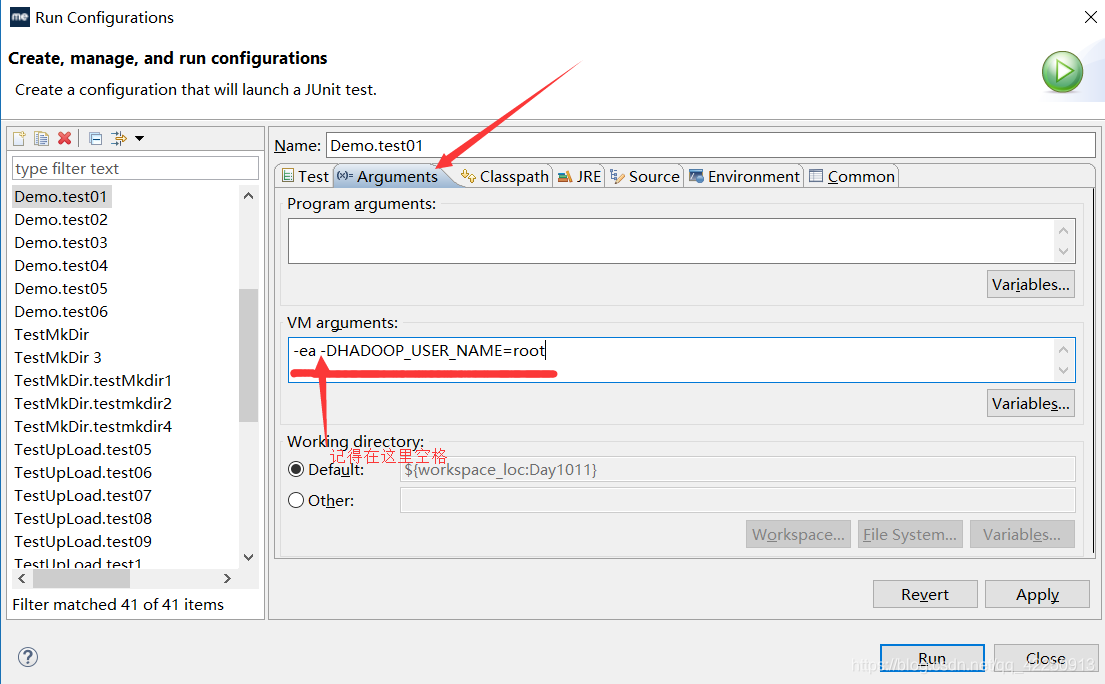

第二种方式:通过java的-D方式参数,-D可以理解是取参数的,如图所示:

第三种方式:dfs.permissions –>false ; 默认是ture,修改就行。

第四种方式:命令 -chmod 改变hdfs的目录权限

java api 操作hdfs时需要关闭防火墙,安全模式,启动hdfs

sudo ufw disable

hdfs dfs -safemode leave

start-dfs.sh

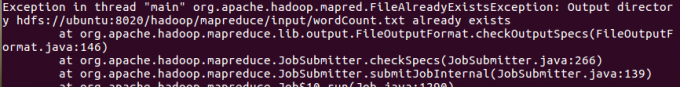

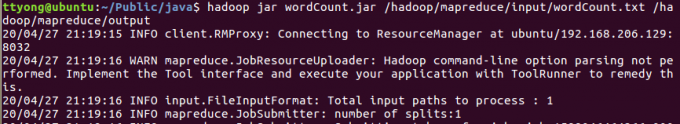

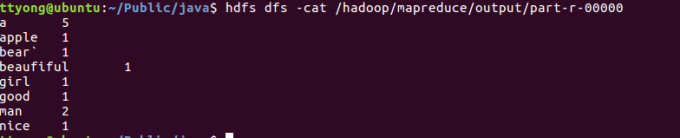

hadoop命令行执行mapreduce作业时报错

output输出路径已存在

解决:

输出路径不能已存在

命令中不需要主文件参数:

1 | hadoop jar xxx.jar input路径 output路径 |

使用java api 操作hdfs时接口传字符,需要是双引号

可以传达自己的思想,但是没必要同化他人。